※本記事は、データ活用に関する最新の取組みや業界動向をより多くのかたにお届けするために、JDMC ホームページと株式会社ジールが運営するメディア「BI online」に掲載しています。

はじめに

日本データマネジメント・コンソーシアム(JDMC)では、様々な研究会を運営しています。その研究会のひとつである「AI・データ活用のためのコンプライアンス研究会」は、7月29日にオープンセミナーを実施しました。

データを活用する時に法令を遵守することは当然ですが、倫理的な観点でも配慮しておかないと結果的に炎上してしまう事例を目にすることがよくあります。このような事態にならないように、法令遵守だけではなく倫理的な観点で何を確認すべきなのかということをこの研究会では考えてきました。

前半は、西村あさひ法律事務所 福岡 真之介 氏から「AI・データ活用における倫理上の問題のポイント」について講演され、後半は、研究会の発表としてSBIホールディングス株式会社 佐藤 市雄 氏、日本電気株式会社 安井 秀一 氏、マクニカネットワークス株式会社 神嶌 潔 氏から「データ活用が引き起こす問題を未然に防ぐ」について講演されました。

1.講演「AI・データ活用における倫理上の問題のポイント」

西村あさひ法律事務所 パートナー弁護士 福岡 真之介 氏

Ⅰ.倫理とは

倫理には「社会の規範」と「自己の行動規範」の2つがあります。

例えば、嘘を言ってはいけないということは、社会のルールとしての側面と、個人的に気分が悪いという面と2つの観点があります。AI・データの倫理については、社会のルールについてよく強調されますが、個人の内面についての側面も忘れてはならない大きな要素の1つです。

また、哲学者が倫理について様々な議論をしており、功利主義(帰結主義)、義務論、徳倫理、相対論、ニヒリズムなど、いろいろな説があります。

AI・データの倫理について考えた場合、技術の発展、経済的発展と安全、プライバシーは相克する問題としてよく言われています。例としてコロナ感染を追跡するためにスマホで行動を監視し接触確認をすべきか否か、ということが倫理的な問題としてあります。

功利主義的な発想でいくならば、人の命というのは、相対的に最大幸福をどう考えるべきかという問題に落とし込めるのかもしれませんが、義務論でいくと、人の命を守ることは価値が高いので、プライバシーを犠牲にしても全員に強制的に導入すべきだという発想になってもおかしくありません。これは、どのような考え方をとるかによって変わってきます。

Ⅱ.各国のAI倫理原則

AIに関して、いろいろな倫理原則が各国で設けられています。

日本のAI倫理原則

日本では、人間中心のAI社会原則ということが打ち立てられており、どのように実務に落とし込むか、ということが求められています。そのほか、AI開発原則、AI利活用原則などが設けられています。

各国に共通するAI倫理原則

OECD、EU、US(IEEE)などのAI倫理原則をみていくと、大体同じような内容になっており、各国に共通するものを抽出すると下記の通りになります。

-

人間の尊重

-

Well-being(良い社会、良い生活)

-

安全性

-

プライバシー

-

公平性

-

透明性

-

アカウンタビリティー(説明責任)

-

セキュリティ

Ⅲ.AI・データ倫理に対する企業の取り組み

AI・データの倫理に取り組む企業として、外国企業ではGoogleやマイクロソフト、IBMのような企業が倫理原則を作り公開しています。日本企業としてはSony、富士通、日立、NTT、NEC、Zホールディングスなどの企業が、倫理原則を公表しています。今後も続々と増えていくことが予想されます。

Ⅳ.AI・データ倫理が問題となった事例

世界各国においてもAI倫理原則がある程度確立してきている現状で、それをどう実装していくか、具体化していくかということが問題になっていいます。では、実際どういったことが問題になったのか、過去の事例をご紹介します。

■人間の尊重、Well-being

・Tay事案

2016年3月にマイクロソフトがリリースしたAIが入っているチャットボット。Twitter上で、質問に対して、リプライする仕組みになっていて、24時間以内に5万人のフォロワーを獲得。しかし、ヘイト発言を繰り返すようになり停止。ユーザーが繰り返し人種差別的な発言をしたことが原因。

・韓国のチャットボット「イ・ルダ」

2020年12月23日リリース。カカオトークの利用者会話100億件に基づいて作成されましたが、ヘイト発言を繰り返すようになりサービス停止に至る。

■公平性

公平性の問題というのは、AIには、必然的に伴ってくる問題です。AIを利用する上で、学習用データが必須ですが、この中にバイアスが入る可能性がありますし、また、アルゴリズム自体の中にバイアスが入っている可能性もあります。

・アマゾン事案

AIによる採用システム。履歴書の中に女性に関する単語が入っていると評価が下がる傾向にあることが判明。結果的にこのシステムは採用されなかった。

・アップルカード事案

妻の方が、与信スコアが高いにもかかわらずアップルカードでは、夫が妻の20倍の利用限度額で設定されていると主張される。NY金融サービス局が調査した結果、性差別を示す証拠は見つからなかったと報道。このようなことは代理変数の問題にもなってきます。いわゆる直接的なデータではなくても体重・身長などによって性別が判別できたり、居住地によって人種が類推できたりします。

・COMPASS事案

米国ノースポイント社が開発した裁判予測プログラム。アメリカの裁判所では、罪をもう一度犯す可能性を示すプログラムを採用しています。被告に137の質問に答えさせ、過去の犯罪データとの照合により犯罪する危険性を10段階の点数として割り出すシステム。実際のデータを見てみると黒人が不利になったのではないかと言われています。

■プライバシー

・SUICA事案(2013)

JR東日本がSUICAのデータを日立に提供した事案です。契約の中では、特定の個人を示すことを禁止する契約を締結していましたが、本人の同意を取っていなかったので、批判され炎上し、結果的にはこのプロジェクトは頓挫しました。

・NICT事案 (2013)

大阪ステーションシティにおいて、カメラを設置し、顔画像の認識を行い、人流を把握し、災害が起こった時の避難経路を分析するプロジェクトでしたが、炎上し中止となりました。

・渋谷書店万引対策共同プロジェクト

万引き防止のために3書店が万引き犯の顔の情報共有を行う。一年間で40人53件を登録し、犯罪抑止効果につながっている。NICTの事案と同じようなケースですが、現在も実施されており、炎上していません。社会とのコミュニケーションのやり方によって、うまくいっているケースです。

・リクナビ事案

何が問題だったのか?というところですが、個人情報の部分があったと認定されています。倫理的に言うと、パーソナルデータを提供した人の想定外の目的に利用されたことです。具体的には、内定辞退率に使われたことによって、本人が裏切られたというころもあったと思うし、就職活動という人生に大きな影響が出る場合に利用されたというところです。また誤りを修正するメカニズムがないところも問題でした。

・破産者マップ事案

破産者の住所や名前は官報に公開されていますが、それをGoogle Mapにマッピングして公開。問題点は、すでに公開されている情報でも、可視化することによって、プライバシーの侵害具合が一気に高まる典型的な例です。公開されている情報だから良いという単純な話ではなく、公開されていることと公開されている情報を整理して可視化することで、全然違うものになるという認識が必要です。

・LINE事案

LINEのデータに中国、香港からもアクセスできたということで、違法ではありませんでしたが、適切な勧告がされなかったということがありました。LINEほどインフラ化していて、みんなが使うものについて、その適切の対応をとっていなかったことが問題であり、そういう意味ではLINEの特殊性というか、みんなが使っているということで大きな影響を与えたことだと思われます。違法ではなかったとしても、社会的には色々言われてしまうところは大きい問題です。合併など企業が急成長するときには、ガバナンスの問題は起こりやすいという印象を持っています。

「AI・データ活用における倫理上の問題のポイント」のまとめ

対策としては、1つは設計段階、作成段階、品質問題など技術的に対応できるものもありますので、エンジニアの方が重要になってきます。また使い方の問題、利用者の問題もあります。ユーザーが非常に悪意のある人たちばかりだったとしても、それは言い訳にはなりません。それは、どうしようも無いのではという話もありますが、説明文書などで警告や注意を促す、あとは契約の中で制限をしたり、常にモニタリングしていくことが必要になってきます。また非技術的な対応になりますが、ガバナンスを強化して対応していくことも重要です。

※(参考)AI原則実践のためのガバナンス・ガイドライン ver. 1.0 出典:経済産業省ウェブサイト

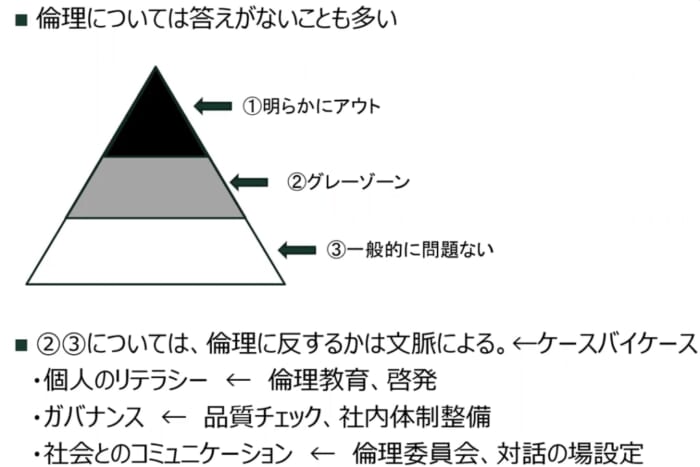

倫理に関しては答えがないことも多くあります。問題は上記の図の②、③の部分です。グレーゾーンといわれる部分や一般的に問題ないといわれる部分について気を付けなくてはなりません。倫理に反するかは文脈によりますので、個人のリテラシーが重要になってきます。そのために倫理教育や啓発も必要になってきます。また、品質チェックや社会体制の整備などガバナンスを強化するのも1つの手法です。

社会のコミュニケーションについて何が悪いのか簡単にわからない時代になってきていますので、倫理委員会を設けて対話をする事で、社会とのコミュニケーションを図っていくということも重要になってきます。

2.研究発表「AI・データ活用が引き起こす問題を未然に防ぐ!」

SBIホールディングス株式会社 社長室 次長 佐藤 市雄 氏

日本電気株式会社 デジタルビジネスプラットフォームユニット サービスプラットフォーム事業部 シニアエキスパート 安井 秀一 氏

マクニカネットワークス株式会社 DX事業部 CPソリューション室 主席 神嶌 潔 氏

Ⅰ.研究会活動概要

様々な産業において、AI・データの活用は、なくてはならないものになってきています。しかし、その一方で企業のビジネス活動にあたって、様々なコンプライアンス、倫理的な問題というものが浮き彫りになるケースが増えています。

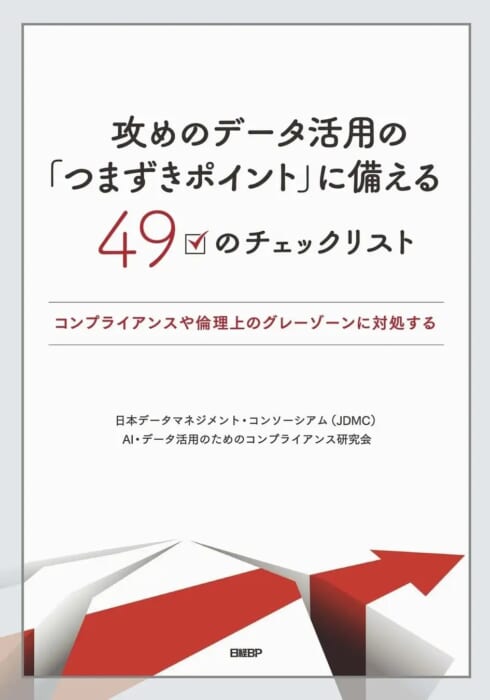

研究会においては、こういったデータの活用の拡大やAI活用の幅が広がるところに着眼して、どのようなコンプライアンス、倫理的な課題があるのかをディスカッションし、データを活用していく人たちが現場で使えるようなものをフレームワークとして作成しました。

研究会に参加される方は、AI・データを使って新しいビジ ネスを考えている方や、データ活用においてコンプライアンス、個人情報で悩まれている実務の方、法務担当の方と一緒に研究していきたいと考えています。また、「AI・データにおける倫理ってなんだろう?」と思われている方にも参加いただきたいと考えています。

Ⅱ.つまずきポイントとその洗い出し

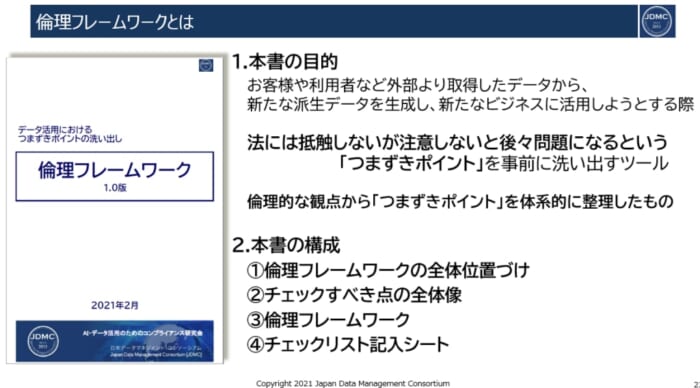

データ活用にあたって問題となるつまずきポイントがどういった背景から生じるのかを踏まえて、それらを洗い出すためのツールとして、本研究会にて開発を進めてきた倫理フレームワークをご紹介します。

■ つまずきポイントとは?

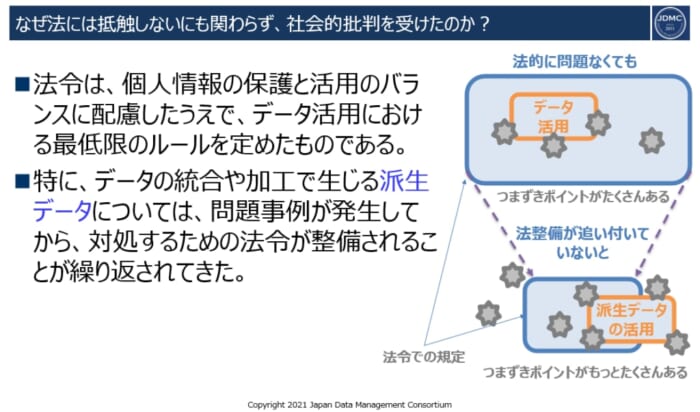

法令には抵触しないにも関わらず、社会的批判を受ける。

そのため、データ活用そのものを断念したり、大幅な方針変更を余儀なくされる。

ではなぜこのようなことが起きるのでしょうか?

それは、個人情報保護法をはじめとした法令は、定められているルールやその対象は最低限のものとなっています。特にデータの統合や加工で生じる派生データと、その取扱いに関するルールについては法令の対応が後回しになっています。

■ 問題事例から法令の整備につながった例

交通系ICカード・データ販売問題(2013)→「匿名加工情報」とその取扱いに関する規定が追加(2015年度改正)

内定辞退率の予測データ提供問題(2019)→「個人関連情報」とその取扱いに関する規定が追加(2020年度改正)

データ活用の推進にあたっては、法令を重視することはもちろんですが、法令がまだ整備されていないような領域でのデータ活用においても、つまずきポイントを見つけ出して回避することが必要となります。

本研究会では、つまずきポイントを洗い出すためのツールの開発を試み、その成果として倫理フレームワークを作成しました。

Ⅲ.倫理フレームワーク

つまずきポイントを見つけ出すことをまとめたものが倫理フレームワークと定めています。

倫理フレームワークでは、使いやすさ、わかりやすさを重視しています。

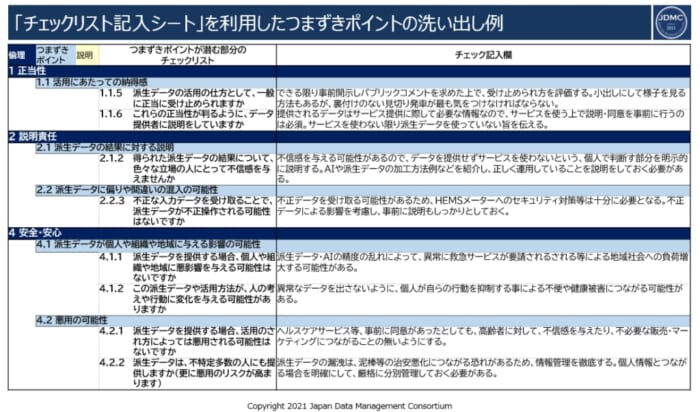

つまずきポイントが潜んでいないかどうかを見つけていくために、ポイントはすべて質問形式でまとめています。この質問は、倫理フレームワークと別紙という形になっており、記入シートを用意しています。

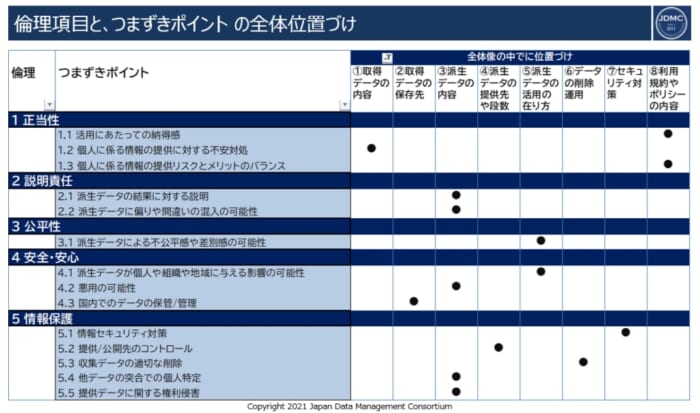

上記が倫理フレームワークの全体像を示しているものになります。

データの流れに基づいて、実務的にはどこが重要なポイントになるのか、ということを整理したものが横軸になります。倫理に基づいてどこがつまずくポイントなのかを見つけるための項目が縦軸になります。この倫理の項目5つについては、時代が変わっていったとしても、大きく変わることはないものを選んでいます。

Ⅳ.つまずきポイントの洗い出し事例

では、実際にフレームワークが使えるのかということを想定の事例を使って、つまずきポイントの洗い出しを実践しました。

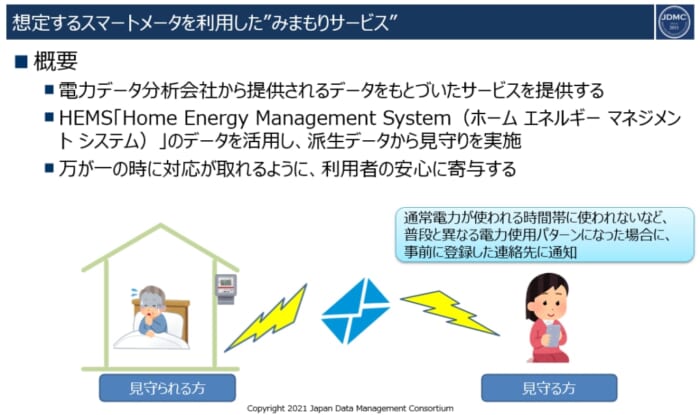

スマートメーターのデータを使った見守りサービスを想定しました。実際にはないサービスですが、ありそうなサービスなので具体的に感じてもらえるものになっています。

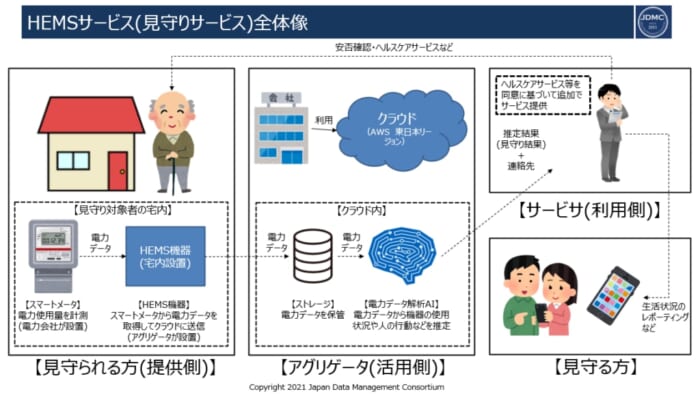

提供された電力データに基づいてサービスを提供する事業者というものがあります。HEMS(Home Energy Management System)のデータを活用するわけですが、実際の出てきたデータだけではなく、ここから派生データを作って見守りサービスを実施します。見守りの方に連絡がいき、関連したサービスの方にも直接連絡がいきサポートされる、といったものになります。電力のデータが、どういった時間にどんな電力が使われていたのかということで、普段と違うようなパターンで利用された場合に関して、様々なアクションが行われるといったものになります。

利用側は、単純に見守りをするだけではなく、さらに提供側の同意を得て、追加のサービスを提供する可能性がある想定です。

それでは、チェックリストに記入していく前に、留意点についてお話します。

ここでは、派生データが非常に重要になってきます。主体が、電力会社→活用側→サービスを提供する利用者側というようにどんどん変わっていきますので、サービサ(利用側)は、見守られる方(提供側)から正しく同意を得ることが重要です。見守られる方は、基本的に高齢者が多いので、サービスを受けるにあたって、どのようなことを感じられるのか、その感じ方によって、不適切な販売とかマーケティングにならないのか、遠くにいる見守る方との関係性に配慮した同意が取れているのか、ということを十分に考慮して考えなくてはなりません。また、あってはならないことですが、従業員の不正、情報漏洩、盗難、そういった様々なことに対しても考えて書いていく必要があります。

上記の通り実際に書いてみたのですが、2、3時間かかりました。実務でやる場合は、関係者が集まってワークショップのような形で記入していくことが想定され1~2日は要するかと思います。このように時間がかかりますが、リスクが下げられますので、コストとしては十分問題ないと考えています。

Ⅴ.まとめと今年度の活動方針

昨年度を振り返ると、想定した以上にきちんと取り組めてアウトプットが出せたというのは良かったと思います。一方、つまずきポイントだけではなく、解決策も欲しいということもありましたので、これを今年の研究の課題としました。つまずきポイントを洗い出すといったフレームワークにとどまらず、どういった形で解決していけばいいのか、導き出すための糸口、方法論を議論していく予定です。また外部発信を進めていくために、昨年度のフレームワークについての精査・査読を進めて、一般公開に向けて取り組んでいきます。

また情報のアップデート等も日々行う必要があります。令和2年の個人情報保護法改正やAI原則など様々検討が進んでおりますので、これらを見据えて議論を進めていきます。

さらに、外部との連携の強化、そして研究会のメンバーの募集を行っています。外部の団体の連携の強化は、一般に広く公開するよりは一部の連携していただける団体に情報を公開して意見を求めたり、人的交流や成果物の共有という形で活用している段階となっています。今後もメンバーを増員し、取り組みを強化していく予定です。